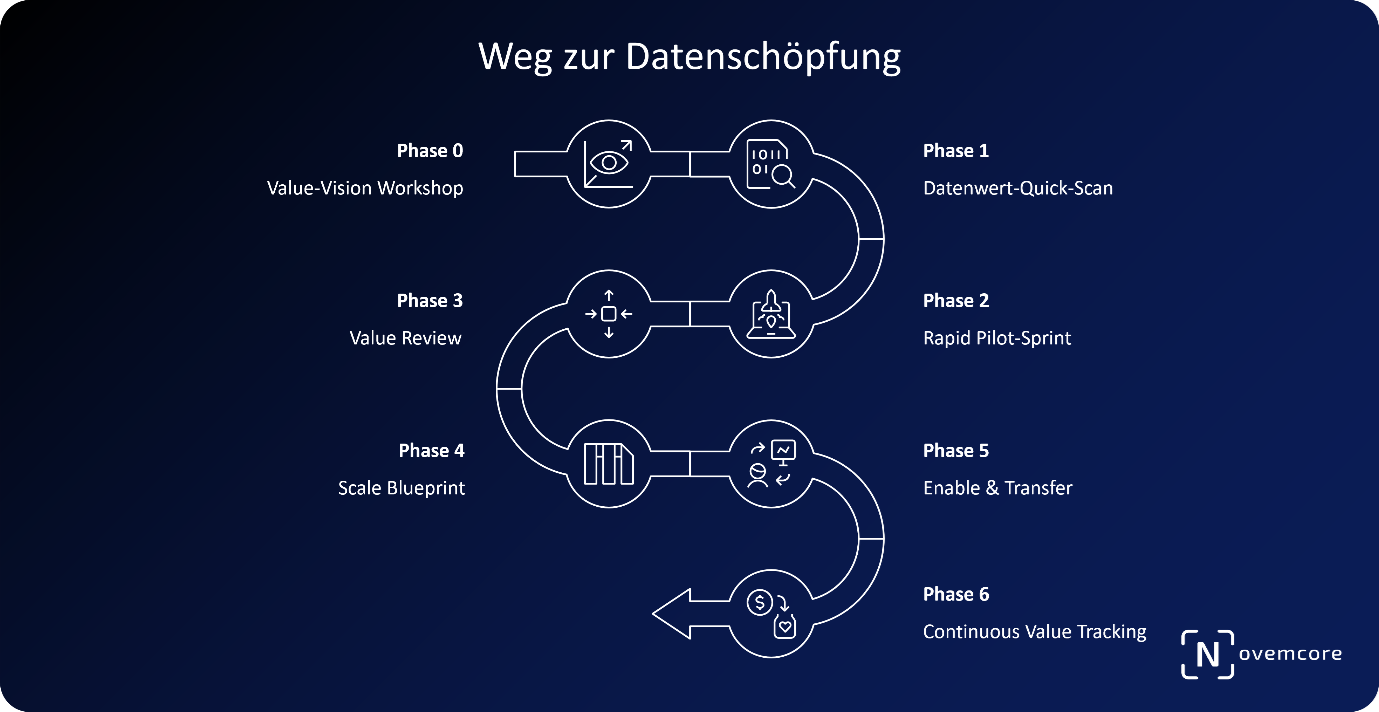

Strukturiert zum Datenwert: Das sechsstufige Vorgehensmodell zur erfolgreichen Realisierung datengetriebener Wertschöpfung

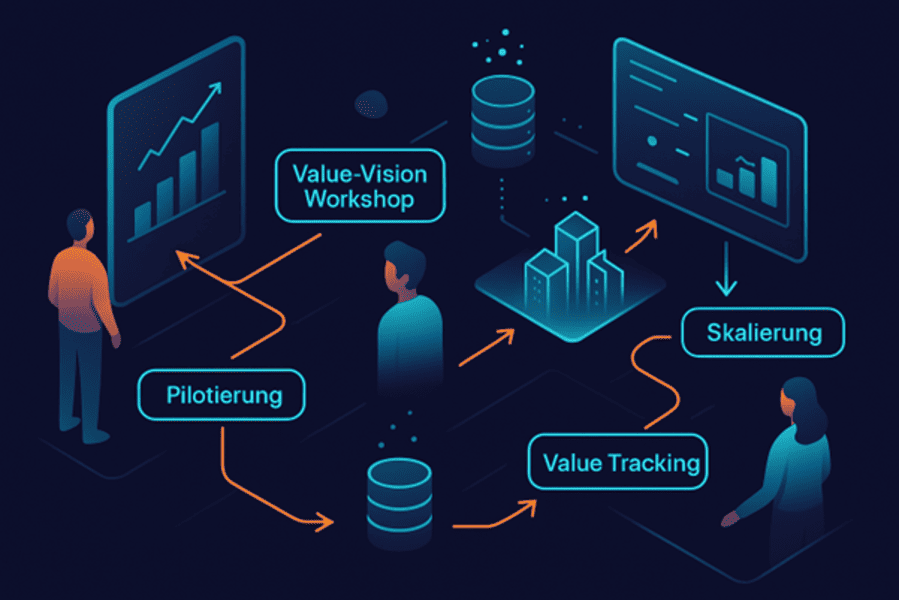

Viele Datenprojekte scheitern an fehlendem Fokus, nicht an Technik. Das Data Value Framework von Novemcore führt in sechs Phasen – von Vision bis Value Tracking – zu messbarer Datenwertschöpfung. Mit klaren Methoden, KPIs und praxisnaher Umsetzung gelingt schnelle, skalierbare Wirkung.

Viele datenbezogene Initiativen scheitern nicht an der Technologie, sondern an unklarem Vorgehen, mangelnder Fokussierung oder übermäßiger Komplexität. Das von Novemcore entwickelte sechsstufige Vorgehensmodell bietet einen pragmatischen, wertorientierten Rahmen für den Aufbau datenbasierter Wertschöpfung – von der strategischen Zieldefinition bis zur operativen Verankerung im Unternehmen.

Phase 0: Value-Vision Workshop

Der Einstieg beginnt mit einem eintägigen Workshop, der Ziele, Erwartungen und Prioritäten schärft. Gemeinsam mit den Stakeholdern wird das Data Value Canvas durchlaufen: identifizierte Geschäftsziele, vorhandene Datenquellen, regulatorische Rahmenbedingungen und organisatorische Herausforderungen. Das Ergebnis ist eine priorisierte Liste von datenbasierten Use Cases inklusive Business Impact und KPIs. Ziel ist es, ein gemeinsames Verständnis zu schaffen, Aktionismus zu vermeiden und frühzeitig ein Wertversprechen zu formulieren.

Phase 1: Data Value Quick Scan

Innerhalb weniger Tage erfolgt eine kompakte Standortbestimmung. Novemcore bewertet systematisch die Dimensionen Data Availability, Usage und Quality und berechnet den Data Leverage Index (DLI). Gleichzeitig werden der Monetization Value Index (MVI), Reifegradfaktoren (RF) und Alleinstellungsmerkmale (Uniqueness) zum Data Value Factor (DVF) zusammengeführt. Das Ergebnis ist ein Benchmark-Vergleich, der Stärken, Schwächen und Quick-Win-Potenziale offenlegt. Ergänzend erhält der Kunde eine Scorecard mit konkreten Handlungsfeldern.

Phase 2: Rapid Pilot Sprint

Der identifizierte Use Case mit dem besten Kosten-Nutzen-Verhältnis wird in einem Sprint pilotiert. Ein kleines, cross-funktionales Team realisiert eine Ende-zu-Ende-Datenpipeline – etwa ein Churn-Prediction-Modell oder ein Vertriebsdashboard. Dank vordefinierter Cloud-Templates (z. B.Snowflake + dbt + Power BI oder Databricks + MLflow + Feature Store) steht das Minimal Viable Product (MVP) schnell produktiv bereit. Die Wirkungen auf Business-KPIs werden direkt gemessen – z. B. durch zusätzliche Umsatzpotenziale oder Einsparungen im operativen Prozess.

Phase 3: Value Review

Nach dem Go-live wird die Performance des Piloten analysiert. Die realen Ergebnisse (z. B. Conversion Uplift, Kostenreduktion, Forecast-Genauigkeit) werden mit den Hypothesen aus dem Canvas verglichen. Ein C-Level-Briefing zeigt die Wirtschaftlichkeit des Piloten, benennt Lessons Learned und enthält eine Empfehlung für Skalierung, Anpassung oder Stopp. Dieser transparente Review sichert die unternehmerische Steuerbarkeit und fördert Akzeptanz bei Management und Fachbereichen.

Phase 4: Scale Blueprint

Ist der Pilot erfolgreich, erfolgt die Skalierung. Novemcore entwickelt eine Zielarchitektur (z. B. Lakehouse-Ansatz, DataOps-Strukturen, Governance-Modelle) sowie eine Roadmap über 12 bis 18 Monate. Bestehende Quick-Wins werden produktiv überführt, neue Use Cases werden in logischen Clustern ergänzt. Eine Ressourcenschätzung, Budgetrahmen und Skill-Gap-Analyse machen die Umsetzung realistisch planbar. So entsteht eine skalierbare Plattform, die systematisch Mehrwert aus Daten schöpft.

Phase 5: Enable & Transfer

Ziel ist es, die Wertschöpfungskompetenz im Unternehmen selbst zu verankern. Novemcore begleitet gezielt mit Playbooks, Trainings, Pair Programming und Coaching. Ein internes Data Value Office wird aufgebaut, Rollen und Verantwortlichkeiten (z. B. Data Product Owner, Domain Steward) werden definiert. Das Ziel: Nach sechs Monaten sollten weniger als 20 % externe Unterstützung notwendig sein – das Unternehmen kann neue datenbasierte Use Cases eigenständig identifizieren, bewerten und umsetzen.

Phase 6: Continuous Value Tracking

Abschließend wird ein dauerhaftes Monitoring etabliert. Ein Data Value Cockpit visualisiert Fortschritte entlang von KPIs wie DLI, DVF oder Data-to-Revenue-Ratio. Quartalsweise Reviews helfen, neue Use Cases zu priorisieren, bestehende zu archivieren oder weiterzuentwickeln. Das Prinzip: Nur messbarer Wert bleibt im Fokus. Das Unternehmen etabliert einen kontinuierlichen Innovationszyklus – den Data Value Flywheel –, der Daten dauerhaft als Renditequelle nutzt.

Häufige Fragen (FAQ):

1. Warum scheitern viele Datenprojekte?

Oft fehlen klare Ziele, messbare KPIs und eine strukturierte Umsetzung – technische Tools allein reichen nicht für nachhaltige Datenwertschöpfung.

2. Was ist ein datengetriebener Use Case?

Ein konkretes Geschäftsszenario, bei dem Daten systematisch genutzt werden, um z. B. Prozesse zu optimieren, Kosten zu senken oder Umsätze zu steigern.

3. Wie startet man eine erfolgreiche Datenstrategie?

Mit einer klaren Zieldefinition, Business-Priorisierung und der Auswahl skalierbarer Anwendungsfälle – idealerweise unterstützt durch Workshops und initiale Pilotierung.

4. Was ist ein Data Pilot oder MVP im Datenkontext?

Ein Minimalprodukt, das einen Use Case mit echten Daten schnell und messbar umsetzt – als Testlauf für Skalierung und Business Impact.

5. Welche KPIs messen den Erfolg von Datenprojekten?

Typische Kennzahlen sind z. B. Data-to-Revenue Ratio, Forecast Accuracy, ROI datenbasierter Initiativen oder Einsparpotenziale durch Prozessautomatisierung.

6. Was versteht man unter Datenmonetarisierung?

Die gezielte wirtschaftliche Nutzung von Daten – entweder intern zur Effizienzsteigerung oder extern über neue Services, Produkte oder Datenverkäufe.

7. Wie lassen sich Datenprojekte imUnternehmen verankern?

Durch klare Rollen (z. B. Data Product Owner), Governance-Strukturen und kontinuierliches Monitoring – kombiniert mit Schulungen und internem Know-how-Aufbau.

8. Was ist ein kontinuierlicher Datenwertschöpfungsprozess?

Ein iteratives Vorgehen, bei dem datenbasierte Initiativen regelmäßig überprüft, erweitert und skaliert werden – oft als „Data Flywheel“ beschrieben.

Strukturiert zum Datenwert: Das sechsstufige Vorgehensmodell zur erfolgreichen Realisierung datengetriebener Wertschöpfung

Viele Datenprojekte scheitern an fehlendem Fokus, nicht an Technik. Das Data Value Framework von Novemcore führt in sechs Phasen – von Vision bis Value Tracking – zu messbarer Datenwertschöpfung. Mit klaren Methoden, KPIs und praxisnaher Umsetzung gelingt schnelle, skalierbare Wirkung.

Viele datenbezogene Initiativen scheitern nicht an der Technologie, sondern an unklarem Vorgehen, mangelnder Fokussierung oder übermäßiger Komplexität. Das von Novemcore entwickelte sechsstufige Vorgehensmodell bietet einen pragmatischen, wertorientierten Rahmen für den Aufbau datenbasierter Wertschöpfung – von der strategischen Zieldefinition bis zur operativen Verankerung im Unternehmen.

Phase 0: Value-Vision Workshop

Der Einstieg beginnt mit einem eintägigen Workshop, der Ziele, Erwartungen und Prioritäten schärft. Gemeinsam mit den Stakeholdern wird das Data Value Canvas durchlaufen: identifizierte Geschäftsziele, vorhandene Datenquellen, regulatorische Rahmenbedingungen und organisatorische Herausforderungen. Das Ergebnis ist eine priorisierte Liste von datenbasierten Use Cases inklusive Business Impact und KPIs. Ziel ist es, ein gemeinsames Verständnis zu schaffen, Aktionismus zu vermeiden und frühzeitig ein Wertversprechen zu formulieren.

Phase 1: Data Value Quick Scan

Innerhalb weniger Tage erfolgt eine kompakte Standortbestimmung. Novemcore bewertet systematisch die Dimensionen Data Availability, Usage und Quality und berechnet den Data Leverage Index (DLI). Gleichzeitig werden der Monetization Value Index (MVI), Reifegradfaktoren (RF) und Alleinstellungsmerkmale (Uniqueness) zum Data Value Factor (DVF) zusammengeführt. Das Ergebnis ist ein Benchmark-Vergleich, der Stärken, Schwächen und Quick-Win-Potenziale offenlegt. Ergänzend erhält der Kunde eine Scorecard mit konkreten Handlungsfeldern.

Phase 2: Rapid Pilot Sprint

Der identifizierte Use Case mit dem besten Kosten-Nutzen-Verhältnis wird in einem Sprint pilotiert. Ein kleines, cross-funktionales Team realisiert eine Ende-zu-Ende-Datenpipeline – etwa ein Churn-Prediction-Modell oder ein Vertriebsdashboard. Dank vordefinierter Cloud-Templates (z. B.Snowflake + dbt + Power BI oder Databricks + MLflow + Feature Store) steht das Minimal Viable Product (MVP) schnell produktiv bereit. Die Wirkungen auf Business-KPIs werden direkt gemessen – z. B. durch zusätzliche Umsatzpotenziale oder Einsparungen im operativen Prozess.

Phase 3: Value Review

Nach dem Go-live wird die Performance des Piloten analysiert. Die realen Ergebnisse (z. B. Conversion Uplift, Kostenreduktion, Forecast-Genauigkeit) werden mit den Hypothesen aus dem Canvas verglichen. Ein C-Level-Briefing zeigt die Wirtschaftlichkeit des Piloten, benennt Lessons Learned und enthält eine Empfehlung für Skalierung, Anpassung oder Stopp. Dieser transparente Review sichert die unternehmerische Steuerbarkeit und fördert Akzeptanz bei Management und Fachbereichen.

Phase 4: Scale Blueprint

Ist der Pilot erfolgreich, erfolgt die Skalierung. Novemcore entwickelt eine Zielarchitektur (z. B. Lakehouse-Ansatz, DataOps-Strukturen, Governance-Modelle) sowie eine Roadmap über 12 bis 18 Monate. Bestehende Quick-Wins werden produktiv überführt, neue Use Cases werden in logischen Clustern ergänzt. Eine Ressourcenschätzung, Budgetrahmen und Skill-Gap-Analyse machen die Umsetzung realistisch planbar. So entsteht eine skalierbare Plattform, die systematisch Mehrwert aus Daten schöpft.

Phase 5: Enable & Transfer

Ziel ist es, die Wertschöpfungskompetenz im Unternehmen selbst zu verankern. Novemcore begleitet gezielt mit Playbooks, Trainings, Pair Programming und Coaching. Ein internes Data Value Office wird aufgebaut, Rollen und Verantwortlichkeiten (z. B. Data Product Owner, Domain Steward) werden definiert. Das Ziel: Nach sechs Monaten sollten weniger als 20 % externe Unterstützung notwendig sein – das Unternehmen kann neue datenbasierte Use Cases eigenständig identifizieren, bewerten und umsetzen.

Phase 6: Continuous Value Tracking

Abschließend wird ein dauerhaftes Monitoring etabliert. Ein Data Value Cockpit visualisiert Fortschritte entlang von KPIs wie DLI, DVF oder Data-to-Revenue-Ratio. Quartalsweise Reviews helfen, neue Use Cases zu priorisieren, bestehende zu archivieren oder weiterzuentwickeln. Das Prinzip: Nur messbarer Wert bleibt im Fokus. Das Unternehmen etabliert einen kontinuierlichen Innovationszyklus – den Data Value Flywheel –, der Daten dauerhaft als Renditequelle nutzt.

Häufige Fragen (FAQ):

1. Warum scheitern viele Datenprojekte?

Oft fehlen klare Ziele, messbare KPIs und eine strukturierte Umsetzung – technische Tools allein reichen nicht für nachhaltige Datenwertschöpfung.

2. Was ist ein datengetriebener Use Case?

Ein konkretes Geschäftsszenario, bei dem Daten systematisch genutzt werden, um z. B. Prozesse zu optimieren, Kosten zu senken oder Umsätze zu steigern.

3. Wie startet man eine erfolgreiche Datenstrategie?

Mit einer klaren Zieldefinition, Business-Priorisierung und der Auswahl skalierbarer Anwendungsfälle – idealerweise unterstützt durch Workshops und initiale Pilotierung.

4. Was ist ein Data Pilot oder MVP im Datenkontext?

Ein Minimalprodukt, das einen Use Case mit echten Daten schnell und messbar umsetzt – als Testlauf für Skalierung und Business Impact.

5. Welche KPIs messen den Erfolg von Datenprojekten?

Typische Kennzahlen sind z. B. Data-to-Revenue Ratio, Forecast Accuracy, ROI datenbasierter Initiativen oder Einsparpotenziale durch Prozessautomatisierung.

6. Was versteht man unter Datenmonetarisierung?

Die gezielte wirtschaftliche Nutzung von Daten – entweder intern zur Effizienzsteigerung oder extern über neue Services, Produkte oder Datenverkäufe.

7. Wie lassen sich Datenprojekte imUnternehmen verankern?

Durch klare Rollen (z. B. Data Product Owner), Governance-Strukturen und kontinuierliches Monitoring – kombiniert mit Schulungen und internem Know-how-Aufbau.

8. Was ist ein kontinuierlicher Datenwertschöpfungsprozess?

Ein iteratives Vorgehen, bei dem datenbasierte Initiativen regelmäßig überprüft, erweitert und skaliert werden – oft als „Data Flywheel“ beschrieben.